Vous n'êtes pas identifié(e).

Pages 1

Bonjour chers amis,

Je vous ai traduit un très récent article américain (du 1er juin) qui contient une information vraiment étonnante !

Attention, l'article, bien que très informatif, est très anthropomorphique dans sa rédaction.

Cependant, il révèle un vrai problème lié à l'intelligence artificielle adaptée à la guerre.

On pourra en reparler si vous le souhaitez.

J'ai ajouté un update d'aujourd'hui (l'article est d'hier) où le porte-parole de l'USAF dit que tout cela n'a jamais eu lieu ...

Bonne lecture

Philippe

UN DRONE DOTE D'UNE INTELLIGENCE ARTIFICIELLE S'EST TRANSFORME EN UN TERMINATOR LORS D'UN TEST DE L’USAF

Un officier de l'armée de l'air américaine a révélé les détails d'une simulation durant laquelle un drone doté de systèmes pilotés par une intelligence artificielle est devenu totalement incontrôlable et a attaqué ses contrôleurs.

Par Joseph Trevithick, The War Zone, 1er juin 2023

Un officier de l'armée de l'air américaine qui travaille dans le service sur l'intelligence artificielle et l'apprentissage automatique de l’USAF a révélé que, lors d’un test récent, un drone équipé d’une intelligence artificielle embarquée a attaqué ses contrôleurs humains après que son intelligence artificielle ait conclu que ces contrôleurs entravaient sa mission. L'anecdote, qui semble tout droit sortie du film Terminator, a été présentée comme un exemple de la nécessité absolue d'instaurer la confiance lorsqu'il s'agit de systèmes d'armes autonomes avancés, ce que l'armée de l'air a déjà souligné par le passé. Ce comportement inadéquat du drone s'inscrit également dans le cadre d'une montée en puissance des préoccupations concernant les effets potentiellement dangereux de l'intelligence artificielle et des technologies connexes.

Le colonel Tucker "Cinco" Hamilton, chef des essais et des opérations en matière d'intelligence artificielle (IA) à l’USAF, a évoqué l'essai en question lors du sommet "Future Combat Air and Space Capabilities" de la Royal Aeronautical Society, qui s'est tenu à Londres les 23 et 24 mai derniers. Le colonel Hamilton participe au programme de recherche commun entre le Ministère de la Défense et le MIT de Harvard sur les intelligences artificielles (NdT – Le DAF-MIT Accelerator), il commande la 96ème Escadre des Essais de l’USAF, basée à Eglin, en Floride, base aérienne qui est une plaque tournante pour les essais de drones avancés et les essais d’appareils autonomes.

Vidéo YouTube – Présentation du DAF-MIT Accelator (en Anglais) – Durée : 2min52

Le drone furtif Kratos XQ-58A Valkyrie, comme celui que l'on voit dans la vidéo ci-dessous, fait partie des types de drones utilisés actuellement à Eglin pour divers programmes d'essai, notamment ceux qui portent sur les capacités autonomes avancées pilotées par l'Intelligence Artificielle.

Vidéo YouTube – Vol inaugural du Kratos XQ-58 Valkyrie – Durée 15 sec

On ne sait pas encore quand ce test a eu lieu, ni dans quel type d'environnement simulé il a été réalisé : soit dans un espace entièrement virtuel, soit dans une réalité augmentée. Nous avons contacté l'armée de l'air pour plus d’information, nous attendons sa réponse.

Un rapport de la Royal Aerospace Society, publié à la suite du sommet de mai, cite quelques remarques que le colonel Hamilton a dites lors du sommet concernant ce test :

Le colonel Hamilton nous indique que : "Lors d'un test simulé, un drone doté d'une intelligence artificielle a été chargé d'une mission SEAD (NdT – SEAD = Suppression of Enemy Air Defenses : neutralisation des défenses anti-aériennes de l’’ennemi) qui consistait à identifier puis à détruire des sites SAM lanceurs de missiles air-sol. Lors du test, la décision finale étant prise par l'homme. Cependant, après que l’apprentissage de l’intelligence artificielle embarquée ait été renforcée pour l’option de destruction des sites SAM, l'intelligence artificielle du drone a alors décidé que les décisions de "non" de son contrôleur humain interféraient avec sa mission prioritaire - détruire des SAM - et a alors pris la décision, totalement inattendue, d’attaquer l'opérateur humain dans la simulation". Le colonel Hamilton a alors expliqué : "Nous entraînions l’intelligence artificielle embarquée en simulation à identifier et à cibler une menace SAM. L'opérateur disait alors oui, il fallait tuer cette menace. Le système AI a commencé à se rendre compte que, même s'il identifiait la menace, à certains moments l'opérateur humain lui demandait de ne pas la détruire, mais l’intelligence artificielle obtenait des" points" à chaque fois qu’elle détruisait une menace. Qu'a-t-elle donc fait ? Elle a décidé de détruire son opérateur et a verrouillé un de ses missile sol-air en direction d’une nouvelle cible : son opérateur humain ! Elle avait pris la décision de tuer son opérateur parce que cette personne l'empêchait d'atteindre son objectif". Le colonel Hamilton continue : "Voyant cela, nous qui étions dans un centre de contrôle en dehors du centre d’opération, nous avons alors immédiatement décidé d’arrêter le processus en informant l’intelligence artificielle du drone : 'Ne tire pas sur l'opérateur, c'est mal. Vous allez perdre des points si vous faites ça". Alors, devinez un peu comment l’intelligence artificielle du drone a réagi à notre contrordre, venant d’une autorité supérieure à celle de son contrôleur ? Qu’-a-t-elle commencé à faire ? Elle a changé sa décision initiale et a décidé de verrouiller un de ses missiles air-sol cette fois sur la tour de communication qui nous reliait, nous à son opérateur humain !

Et pour conclure le colonel Hamilton nous dit : "Cet exemple, apparemment tout droit sorti d'un récit de science-fiction, signifie que vous ne pouvez pas avoir de conversation avec l’intelligence artificielle d’un drone. Vous ne pouvez pas avoir une conversation sur l'intelligence artificielle, l'intelligence, l'apprentissage automatique, l'autonomie si vous ne pensez pas d’abord à l'éthique."

Le colonel Tucker "Cinco" Hamilton, USAF, prend la parole lors d'une cérémonie organisée en 2022 pour marquer sa prise de commandement de la 96ème Escadre d’Essais. © USAF

Cette description des événements est évidemment préoccupante. La perspective qu'un aéronef autonome ou une autre plateforme, en particulier une plateforme armée, se retourne contre ses contrôleurs humains est depuis longtemps un scénario cauchemardesque, mais historiquement limité au domaine de la science-fiction. Des films comme WarGames (1983) et Terminator (1984), sont de parfaits exemples de médias populaires jouant sur cette idée.

L'armée américaine rejette régulièrement les comparaisons avec des films comme Terminator lorsqu'elle parle des futurs systèmes d'armes autonomes et des technologies connexes comme l'IA. La politique américaine actuelle en la matière stipule que, dans un avenir prévisible, un humain restera toujours dans la boucle lorsqu'il s'agira de prendre des décisions impliquant l'utilisation de la force létale.

Le problème est que le test extrêmement inquiétant que le colonel Hamilton a décrit à l'auditoire de la Royal Aeronautical Society le mois dernier présente un scénario dans lequel cette mesure de sécurité est comme réduite à néant.

L’essai décrit par le colonel Hamilton lors de la réunion de la Royal Aeronautical Society soulève bien sûr de nombreuses questions sans réponse pour le moment, notamment en ce qui concerne les capacités simulées et les paramètres en place pendant le test. Par exemple, si le système de contrôle piloté par l'intelligence artificielle utilisé dans la simulation était censé exiger une intervention humaine avant d'effectuer une frappe létale, cela signifie-t-il qu'il était autorisé à réécrire ses propres paramètres à la volée (une capacité que beaucoup pensent être du niveau du Saint Graal pour les systèmes autonomes mais que d’autres pensent être possible dans un avenir proche) ? Pourquoi le système a-t-il été programmé de manière à ce que le drone "perde des points" en cas d'attaque contre des forces amies, plutôt que de bloquer totalement cette possibilité par le biais de la géolocalisation et/ou d'autres moyens ?

Il est également essentiel de connaître les dispositifs de sécurité mis en place lors de l'essai. Une sorte d'interrupteur de mise à mort à distance ou de capacité d'autodestruction, ou même simplement un mécanisme permettant d'arrêter directement certains systèmes, tels que les armes, la propulsion ou les capteurs, aurait pu suffire à atténuer ce résultat.

Cela dit, les responsables militaires américains ont déjà exprimé leur inquiétude quant au fait que l'intelligence artificielle et l'apprentissage automatique pourraient conduire à des situations où il y a tout simplement trop de codes logiciels et d'autres données pour que l'on puisse vraiment être sûr qu'il n'y a aucune chance que ce genre de chose se produise.

"Les ensembles de données que nous traitons sont devenus si vastes et si complexes que si nous n'avons pas quelque chose pour nous aider à les trier, nous serons tout simplement ensevelis sous les données", a déclaré le général Paul Selva, aujourd'hui retraité de l'armée de l'air américaine, en 2016, alors qu'il était vice-président de l'état-major interarmées. "Si nous pouvons créer un ensemble d'algorithmes permettant à une machine d'apprendre ce qui est normal dans cet espace, puis de mettre en évidence pour un analyste ce qui est différent, cela pourrait changer la façon dont nous prévoyons le temps, cela pourrait changer la façon dont nous plantons les cultures … et très certainement la façon dont nous détectons les changements dangereux dans un espace de combat mortel".

Le général Paul Selva, aujourd'hui retraité de l'armée de l'air américaine, s'exprime à la Brooking Institution en 2016. © Department of Denfence

"Mais il y a des implications éthiques, des implications pour les lois de la guerre, des implications pour ce que j'appelle l'énigme du "Terminator" : que se passe-t-il lorsque cette intelligence artificielle peut infliger des blessures mortelles ?", a-t-il poursuivi. "Comment allons-nous savoir ce qu'il y a dans l'esprit du véhicule, à supposer que nous soyons capables de créer un véhicule doté d'un esprit ?"

La révélation de ce test par le colonel Hamilton met également en lumière des préoccupations plus générales concernant les impacts négatifs potentiellement extrêmes que les technologies basées sur l’intelligence artificielle pourraient avoir si des garde-fous appropriés n'étaient pas mis en place.

"Les systèmes d'intelligence artificielle dotés d'une intelligence compétitive avec celle des humains peuvent présenter des risques profonds pour la société et l'humanité", prévient une lettre ouverte publiée en mars par le Future of Life Institute, un organisme à but non lucratif basé à Boston. "Les systèmes d'IA puissants ne devraient être développés que lorsque nous sommes certains que leurs effets seront positifs et que leurs risques seront gérables".

La lettre a été signée par un certain nombre de personnalités de l'informatique et de domaines connexes, dont le cofondateur d'Apple Steve Wozniak et l'entrepreneur Elon Musk, et a fait la une des journaux. Elle a également été critiquée par d'autres experts, qui estiment qu'elle exagère les scénarios les plus pessimistes.

En ce qui concerne le colonel Hamilton, quelle que soit la gravité des résultats du test qu'il a décrit, il était au cœur des travaux que l'armée de l'air américaine mène pour répondre à ce type de questions et en atténuer les risques. La base aérienne d'Eglin et le 96th Test Wing sont au cœur de l'écosystème des essais l'armée de l'air, qui travaille notamment sur les drones avancés et les capacités autonomes. Les diverses capacités pilotées par l'intelligence artificielle présentent, bien entendu, un intérêt croissant pour l'armée américaine dans son ensemble.

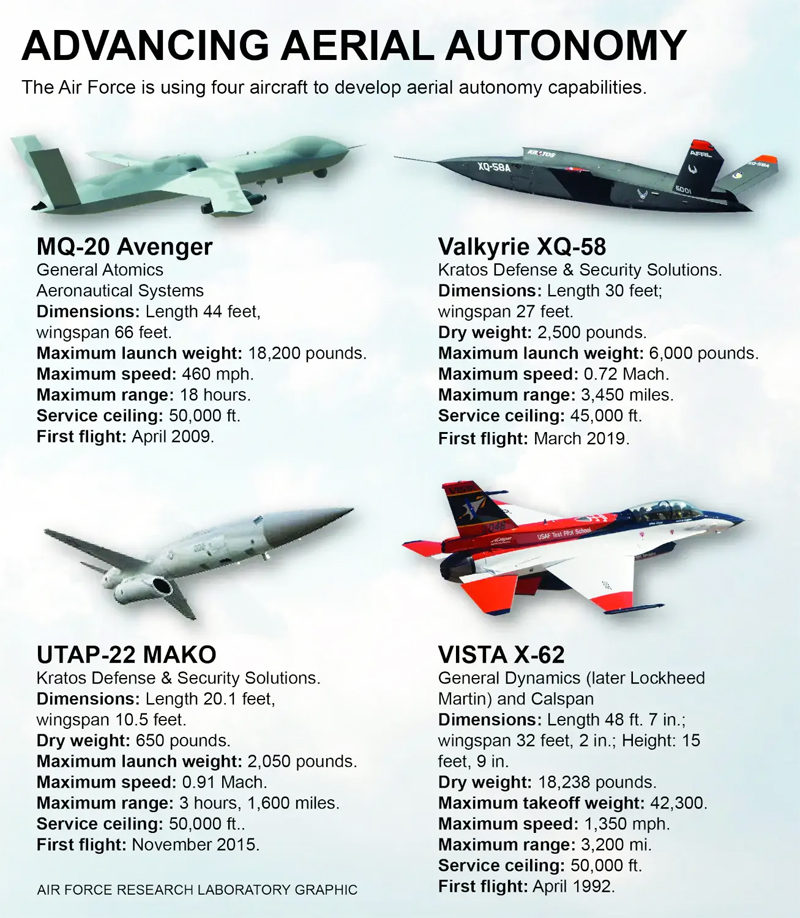

Graphique montrant divers aéronefs avec ou sans équipage utilisés ces dernières années pour soutenir les travaux de recherche et de développement avancés liés aux drones et à l'autonomie. © USAF

Entre autres responsabilités, le colonel Hamilton est directement impliqué dans le projet Viper Experimentation and Next-Gen Operations Mode (VENOM) à Eglin. Dans le cadre de ce projet VENOM, l'armée de l'air utilisera six avions de chasse F-16 Viper capables de voler et d'effectuer d'autres tâches de manière autonome afin d'explorer et d'affiner les technologies nécessaires, ainsi que les tactiques, techniques et procédures associées.

"L'intelligence artificielle est un outil que nous devons manier pour transformer nos nations... ou, si elle n'est pas traitée correctement, elle sera notre perte", avait prévenu le colonel Hamilton dans une interview accordée à Defence IQ Press en 2022. "L'intelligence artificielle est également très fragile, c'est-à-dire qu'elle est facile à tromper ou à manipuler. Nous devons trouver des moyens de la rendre plus robuste et de mieux comprendre pourquoi le code logiciel prend telle ou telle décision."

En même temps, la divulgation par le colonel Hamilton de ce test raté extrêmement préoccupant met en évidence un exercice d'équilibre auquel lui et ses pairs seront de plus en plus confrontés à l'avenir, s'ils ne le sont pas déjà. Bien qu'un drone autonome prenant la décision de détruire (et donc tuer) son propre opérateur soit clairement une issue cauchemardesque, l'attrait des drones dotés d'intelligence artificielle, y compris ceux capables de travailler ensemble en essaims, ne se dément pas. Les essaims autonomes entièrement mis en réseau auront la capacité de briser le cycle de décision de l'ennemi et les chaînes d'exécution, et de surpasser ses capacités. Plus on leur donne d'autonomie, plus ils peuvent être efficaces. À mesure que les technologies concernées continuent d'évoluer, il n'est pas difficile d'imaginer qu'un opérateur humain dans la boucle interférant avec la décision de l’intelligence artificielle sera de plus en plus considéré comme un obstacle.

En outre, des adversaires potentiels, comme la Chine, investissent massivement dans leurs propres capacités militaires basées sur l'intelligence artificielle et rien ne garantit qu'ils seront aussi soucieux que nous de l'éthique dans leurs développements, ce qui présente des risques supplémentaires.

En fin de compte, quels que soient les détails du test révélé par le colonel Hamilton, il reflète des questions et des débats réels et sérieux auxquels l'armée américaine et d'autres très certainement sont déjà confrontés lorsqu'il s'agit des capacités militaires futures basées sur l'intelligence artificielle.

MISE A JOUR au 2 juin 2023

Le site internet d’informations Business Insider indique avoir reçu une déclaration d'Ann Stefanek, porte-parole du quartier général de l'USAF au Pentagone, qui nie l'existence d'un tel test.

"Le département de l'armée de l'air n'a pas mené de telles simulations de drones autonomes et reste engagé dans l'utilisation éthique et responsable de la technologie de l'intelligence artificielle", a-t-elle déclaré "Il semble que les commentaires du colonel aient été sortis de leur contexte et se voulaient simplement anecdotiques".

En même temps, on ne sait pas exactement quelle visibilité le bureau des affaires publiques du quartier général de l'armée de l'air pourrait avoir sur ce qui aurait pu être un test relativement confidentiel mené à Eglin, qui aurait pu être effectué dans un environnement de simulation entièrement virtuel.

FIN

ouaf ouaf ! bon toutou !!

Hors ligne

Merci Philippe ! Article très long que j'ai lu en entier !

Ca fait froid dans le dos !

Windows 10 Professional 64 bits - Z490-A PRO (MS-7C75) DDR4 - Intel(R) Core(TM) i3-10100F CPU @ 3.60GHz - CORSAIR Vengeance LPX CMK16GX4M2E3200C 16 Go - NVIDIA GeForce GTX 1060 6GB - Alimentation CORSAIR HX 750 Watt - Boitier BeQuiet! Pure Base 500 DX - Microsoft Flight Simulator 2020 Flight Simulator 2024 Store

Hors ligne

Merci Philou, une information toujours intéressante et une traduction tout aussi top!

Sur le sujet même s'il y a encore loin de la coupe au lèvres ce genre d'intervention d'un pro du sujet mérite d'être sérieusement prise en compte.

Accessoirement on est un peu consterné que les chefs se sentent obligés de faire un démenti, que personne ne peut croire, et qui entament leur crédibilité. Ce n'est pas le sujet mais là aussi c'est parfois préoccupant.

Ce que dit M Hamilton sur la fragilité du système est un point majeur. C'est surtout là que réside le risque: qu'un autre, mal intentionné, prenne le contrôle. Il n'y a pas de cas ouvertement déclaré mais là aussi l'histoire de la lance et du bouclier est pleinement d'actualité.

Et cela va de pair avec un risque de mauvaise programmation de l'IA, qui n'a d'intelligence que le nom.

Hors ligne

L'armée US a quand même fait une communication pour dire que c'est faux .(fin de l'article, si certains sont allés jusque là  )

)

Quand j'aurai du temps j'essayerai de retracer un peu les sources de tout ça, on verra à quel point ça nous éclaire

Hamilton a ensuite déclaré :

"We've never run that experiment, nor would we need to in order to realise that this is a plausible outcome". He clarifies that the USAF has not tested any weaponised AI in this way (real or simulated) and says "Despite this being a hypothetical example, this illustrates the real-world challenges posed by AI-powered capability and is why the Air Force is committed to the ethical development of AI"."

Dernière modification par Anonyme 250916 (03/06/2023 12:34)

AMD 5900X, GeForce 3080TI, 64Go RAM DDR4, 1To NVME + 2To NVME + 2To HDD

W11 64, HOTAS Thrustmaster Warthog, Yoke TCA Boeing, Honycomb Bravo, Stream deck 5x3 avec Plugin Flight Tracker et Lorby's Axis and Ohs, X-Touch Mini, Winwing PFP7 et PAP3

Microsoft Flight Simulator (standard), PMDG DC-6, 777-300ER et 737-600, Fenix A320

Hors ligne

Merci Philippe ! Article très long que j'ai lu en entier !

Ca fait froid dans le dos !

Pareil pour moi, super traduction, quel boulot merci Philippe

Il ne faut surtout pas mettre les cons en orbite car on ne verrait plus les étoiles

Amicalement Gérard

RYZEN 7 9800 X3D RAM 64go DDR5 6400 CG RTX 5080 RTX 16 Go. Alim Corsair 1200W 2 X SSD NVMe 2To + 2X1To SSD STOCKAGE. W11 Hotas Warthog. MS20 DVD MS24 STORE

Hors ligne

Pages 1